1. 概述与目标

为构建XX集团统一、高效、可信的数据资产体系,提升数据驱动决策能力,本方案聚焦于数据治理体系中的核心环节——数据处理服务。数据处理服务旨在通过标准化、自动化、智能化的技术手段,对原始数据进行采集、清洗、转换、整合与加工,形成高质量、可复用的数据产品与服务,为上层数据分析、应用与决策提供坚实的数据基础。

核心目标:

1. 提升数据质量: 建立端到端的数据质量管控流程,确保数据的准确性、完整性、一致性与时效性。

2. 实现数据标准化: 统一数据定义、口径和模型,消除数据孤岛,促进跨部门、跨系统数据共享与融合。

3. 提高处理效率: 通过自动化流水线与弹性计算资源,缩短数据处理周期,响应快速变化的业务需求。

4. 保障数据安全与合规: 在数据处理全生命周期嵌入安全策略,满足数据安全法与行业监管要求。

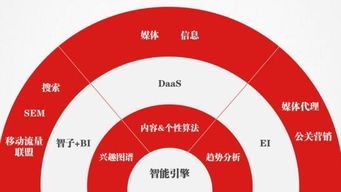

5. 赋能数据应用: 构建面向主题、易于使用的数据服务层,直接支撑精准营销、风险控制、运营优化等业务场景。

2. 总体架构设计

数据处理服务作为数据治理平台的核心引擎,采用分层解耦、服务化的设计思想,其总体架构如下:

┌─────────────────────────────────────────┐

│ 数据应用层 (Data Application) │

│ (报表、分析、风控、营销等业务场景) │

└─────────────────┬─────────────────────────┘

┌─────────────────▼─────────────────────────┐

│ 数据服务层 (Data Service API) │

│ (主题数据服务、指标服务、标签服务、查询服务) │

└─────────────────┬─────────────────────────┘

┌─────────────────▼─────────────────────────┐

│ 数据加工层 (Data Processing) │

│ (ETL/ELT、流处理、数据开发平台、任务调度) │

└─────────────────┬─────────────────────────┘

┌─────────────────▼─────────────────────────┐

│ 数据存储层 (Data Storage) │

│ (ODS、数据仓库DW、数据湖、数据集市DM) │

└─────────────────┬─────────────────────────┘

┌─────────────────▼─────────────────────────┐

│ 数据集成层 (Data Integration) │

│ (实时采集、批量同步、API对接、日志收集) │

└─────────────────┬─────────────────────────┘

│

┌─────────────────▼─────────────────────────┐

│ 数据源层 (Data Sources) │

│ (业务系统、IoT设备、外部数据、文件等) │

└─────────────────────────────────────────┘各层核心功能:

- 数据集成层: 负责从异构数据源(如ERP、CRM、MES、日志、第三方API)进行全量及增量数据采集,支持实时流与批量两种模式。

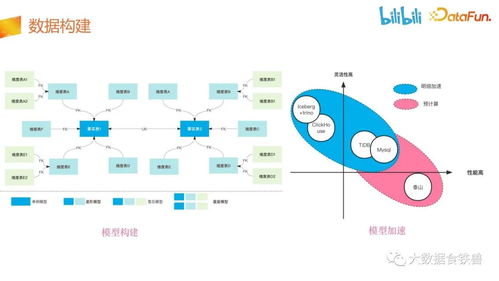

- 数据存储层: 构建贴源数据层(ODS)、统一数据仓库(DW)、数据湖(存储原始数据与半结构化数据)以及面向业务线的数据集市(DM),形成层次清晰的数据存储体系。

- 数据加工层: 核心处理单元。基于可视化或代码化的数据开发平台,完成数据清洗(去重、纠错、标准化)、转换(粒度转换、维度退化)、关联、聚合、复杂计算等任务,并通过统一调度系统有序执行。

- 数据服务层: 将加工后的标准化数据封装成API、数据文件、消息等形式的服务,提供统一的数据访问接口,实现数据与应用的解耦。

- 数据应用层: 直接消费数据服务,驱动各类业务场景。

3. 核心数据处理服务模块

3.1 数据开发与调度平台

- 可视化开发: 提供拖拉拽方式配置数据清洗、转换规则,降低技术门槛。

- 脚本开发: 支持SQL、Python、Spark等脚本开发,满足复杂逻辑需求。

- 任务编排: 图形化编排处理任务间的依赖关系,形成数据处理流水线(DAG)。

- 智能调度: 支持时间、事件、依赖等多种触发方式,具备失败重试、告警、优先级管理等功能。

- 版本管理与协作: 实现数据处理任务的版本控制、发布上线与团队协作开发。

3.2 批流一体处理引擎

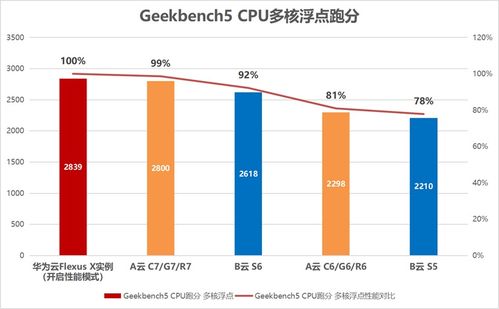

- 批量处理: 针对海量历史数据、T+1业务数据,采用分布式计算框架(如Spark、Hive)进行高效处理。

- 实时流处理: 对接Kafka、Pulsar等消息队列,使用Flink、Spark Streaming等引擎处理实时数据流,满足监控、实时风控等场景的秒级/毫秒级延迟要求。

- 统一API: 探索使用批流一体API(如Flink Table API),实现同一套逻辑对静态数据和动态流数据的处理,简化开发运维。

3.3 数据质量管理服务

- 质量规则库: 预置及自定义完整性、有效性、准确性、一致性、唯一性、及时性等六大类质量规则。

- 流程嵌入: 在数据处理的关键环节(接入、清洗、加工、输出)设置质量检查点,实现“事前预防、事中监控、事后评估”。

- 质量监控与报告: 实时监控数据质量指标,生成质量报告与评分,并自动触发告警或拦截流程。

- 质量整改闭环: 建立质量问题发现、派单、整改、验证的闭环管理流程。

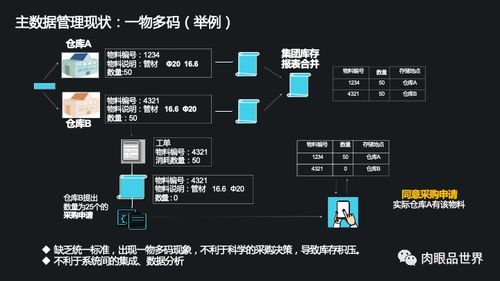

3.4 主数据与参考数据管理服务

- 主数据管理: 对客户、供应商、产品、组织等关键业务实体,实现全集团统一的编码、属性定义、生命周期管理和分发同步。

- 参考数据管理: 统一管理国家代码、行业分类、状态码等标准代码,确保各系统引用一致。

3.5 数据服务化与API管理

- 服务封装: 将数据表、视图、预计算指标、用户标签等,封装成标准的RESTful API或GraphQL接口。

- API网关: 统一接入、认证、鉴权、限流、监控和日志记录。

- 服务目录: 提供可视化的数据服务目录,方便业务人员查找、理解和申请使用。

- 计量与计费: 支持对API调用量的统计,为内部成本分摊提供依据。

4. 实施路线图(建议)

第一阶段:基础搭建与试点(1-6个月)

1. 搭建大数据基础平台(存储、计算资源)。

2. 部署数据集成工具,完成1-2个核心业务系统的数据全量接入。

3. 上线数据开发与调度平台,构建首个主题数据模型(如客户主题)。

4. 在试点业务线(如营销部门)提供初步的数据服务API。

第二阶段:体系完善与推广(7-18个月)

1. 完善数据仓库分层模型,接入主要业务系统数据。

2. 全面部署数据质量管理模块,建立常态化的质量巡检机制。

3. 建立主数据管理体系,解决关键数据一致性问题。

4. 推广数据服务API至更多业务部门,支撑3-5个典型数据应用场景。

5. 引入实时流处理能力,满足实时业务需求。

第三阶段:智能化与价值深化(19-36个月)

1. 探索AI在数据清洗、关联发现、异常检测等方面的应用。

2. 深化数据服务,提供预测性、建议性的智能数据服务。

3. 建立完善的数据资产运营体系,衡量数据服务带来的业务价值。

4. 形成数据驱动的文化,数据处理服务成为集团业务创新与运营的核心支撑。

5. 保障措施

- 组织保障: 明确数据处理服务的归口管理团队(如数据平台部),与业务部门、数据治理委员会紧密协同。

- 技术保障: 选择成熟、开源或商业的技术栈,保证平台的稳定性、扩展性和可维护性。建立容灾备份与监控体系。

- 管理保障: 制定并落实《数据处理服务开发规范》、《数据质量管理办法》、《数据服务API管理规范》等制度。

- 安全与合规保障: 严格执行数据分类分级,在数据处理各环节实施加密、脱敏、访问控制等安全策略,定期进行合规审计。

通过本方案的实施,XX集团将构建起一个敏捷、可靠、智能的数据处理服务体系,使数据得以高效、安全地转化为核心资产,为集团的数字化转型与智能化升级注入强大动力。